jpegoptim JPG图像无损有损压缩 jpegoptim JPG图像无损有损压缩

jpegoptim JPG图像无损有损压缩 jpegoptim JPG图像无损有损压缩

2012/05/29 20:21 | by ipaddr ]

2012/05/29 20:21 | by ipaddr ]

Jpegoptim是一个google建议的很好的JPG,JPEG图像压缩工具,目前支持系统有Linux,Solaris,Darwin/OSX

软件安装需求:

Independent JPEG Group’s jpeg library version 6a or later

安装方法:

下载附件jpegoptim-1.2.3.tar.gz,当然官方地址:http://freshmeat.net/projects/jpegoptim/

tar zxvf jpegoptim-1.2.3.tar.gz

cd jpegoptim-1.2.3

./configure

make

make strip

make install

(依赖于libjpeg-devel包)

使用方法:

jpegoptim --strip-com --strip-exif --strip-iptc tomzhou.jpg

更多用法,可使用jpegoptim --help查看

注:使用 jpegoptim 最常见的问题是,颜色会失真,比如浅蓝色总会变成淡紫色。解决这个的办法是,不要清除掉图片的 ICC 标记(实际上,图片的ICC标记也不大,清除它获得的尺寸减小很有限),即,不要使用 --strip-all ,也不要使用 --strip-icc。

在线代码高亮 CodeMirror

在线代码高亮 CodeMirror

2012/05/29 20:17 | by ipaddr ]

2012/05/29 20:17 | by ipaddr ]

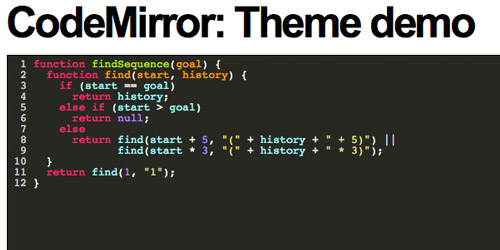

又一款“Online Source Editor”,基于Javascript,短小精悍,实时在线代码高亮显示,他不是某个富文本编辑器的附属产品,他是许多大名鼎鼎的在线代码编辑器的基础库。

本站的在线LESS编译器和Markdown编辑器就是采用这个组件开发。

可以看出,CodeMirror的作者是一个十分向往自由的人。但他的CodeMirror绝对不简单,看看下面这份清单:

- Google Earth KML sampler

- Eloquent JavaScript's console

- The qooxdoo playground

- A cool tutorial about the element

- An online IDE for the Orc programming language

- Google's API playground

- Raphaël Live

- JS Bin

- The RokPad plugin for Joomla

- The scraperwiki editor

- jsLinb UI Builder

上述的这些在线代码编辑器都是基于CodeMirror的,是不是感到惊讶,里面有你熟悉的JS Library。

CodeMirror本身的定位也很明确,短小精悍,但代码质量很高,在Google Group的群里面,人们热烈的进行着用CodeMirror做各式各样改造的讨论,可见对他的欢迎。以下有各种不同语言的Demo演示:

- JavaScript

- XML/HTML

- CSS

- SPARQL

- HTML mixed-mode

- HTML+PHP mixed-mode (courtesy of Yahoo!)

- Python (by Timothy Farrell)

- Lua (by Franciszek Wawrzak)

- Ruby (by Michal Hantl, unfinished)

- SQL (by John Benediktsson)

- PLSQL (by Peter Raganitsch)

- diff (courtesy of Liran Nuna)

- Groovy (by eXo Platform)

- C# (by Boris Gaber and Christopher Buchino)

- OmetaJS (by Eric KEDJI)

- Scheme (by Danny Yoo)

假如你有项目需要在线代码编辑,还等什么?CodeMirror,绝对是你最好的选择。

为了尊重作者对自由的向往,请在使用前认真阅读以下License,并严格尊重作者的声明:

Nginx在Gzip+ Upstream + HEAD模式下的一个Bug

Nginx在Gzip+ Upstream + HEAD模式下的一个Bug

2012/05/10 11:30 | by ipaddr ]

2012/05/10 11:30 | by ipaddr ]

[转]杂谈Nginx与HTTP协议

[转]杂谈Nginx与HTTP协议

2012/05/10 09:54 | by ipaddr ]

2012/05/10 09:54 | by ipaddr ]

在项目中遇到一个问题,需要详细了解下HTTP协议及其Nginx中对HTTP协议的支持程度。今天一天收集了一些资料,也梳理出最终方案。记录到博客上,方便后续查阅。重点关注以下几个方面:1、Http交互中如何判定内容的长度及其HTTP协议中关于Content-Length的解读。2、Chunk和Gzip在Nginx中的实现及原理。3、Upstream如何和Chunked结合。

Http协议中关于Content-Length的解读

在HTTP协议中,有Content-Length的详细解读。Content-Length用于描述HTTP消息实体的传输长度the transfer-length of the message-body。在HTTP协议中,消息实体长度和消息实体的传输长度是有区别,比如说gzip压缩下,消息实体长度是压缩前的长度,消息实体的传输长度是gzip压缩后的长度。

在具体的HTTP交互中,客户端是如何获取消息长度的呢,主要基于以下几个规则:

- 响应为1xx,204,304相应或者head请求,则直接忽视掉消息实体内容。

- 如果有Transfer-Encoding,则优先采用Transfer-Encoding里面的方法来找到对应的长度。比如说Chunked模式。

- “如果head中有Content-Length,那么这个Content-Length既表示实体长度,又表示传输长度。如果实体长度和传输长度不相等(比如说设置了Transfer-Encoding),那么则不能设置Content-Length。如果设置了Transfer-Encoding,那么Content-Length将被忽视”。这句话翻译的优点饶,其实关键就一点:有了Transfer-Encoding,则不能有Content-Length。

- Range传输。不关注,没详细看了:)

- 通过服务器关闭连接能确定消息的传输长度。(请求端不能通过关闭连接来指明请求消息体的结束,因为这样可以让服务器没有机会继续给予响应)。这种情况主要对应为短连接,即非keep-alive模式。

- HTTP1.1必须支持chunk模式。因为当不确定消息长度的时候,可以通过chunk机制来处理这种情况。

- 在包含消息内容的header中,如果有content-length字段,那么该字段对应的值必须完全和消息主题里面的长度匹配。

“The entity-length of a message is the length of the message-body before any transfer-codings have been applied”

也就是有chunk就不能有content-length 。

其实后面几条几乎可以忽视,简单总结后如下:

1、Content-Length如果存在并且有效的话,则必须和消息内容的传输长度完全一致。(经过测试,如果过短则会截断,过长则会导致超时。)

2、如果存在Transfer-Encoding(重点是chunked),则在header中不能有Content-Length,有也会被忽视。

3、如果采用短连接,则直接可以通过服务器关闭连接来确定消息的传输长度。(这个很容易懂)

结合HTTP协议其他的特点,比如说Http1.1之前的不支持keep alive。那么可以得出以下结论:

1、在Http 1.0及之前版本中,content-length字段可有可无。

2、在http1.1及之后版本。如果是keep alive,则content-length和chunk必然是二选一。若是非keep alive,则和http1.0一样。content-length可有可无。

Nginx在Http协议方面的处理

第一、Nginx的chunk模块

Nginx的Chunk模块是一个典型的Filter模块,它本身是内置必选的Nginx模块。在0.7.66版本之后,有一个配置项chunked_transfer_encoding可以开启或者关闭chunk模式,默认是开启的。

首先,先简单了解下在HTTP协议中Chunked相关的知识点。Chunked一种transfer coding方式,在HTTP1.0之前(包含http1.0)的版本是不支持的。在HTTP协议中定义如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 | Chunked-Body = *chunk last-chunk trailer CRLF chunk = chunk-size [ chunk-extension ] CRLF chunk-data CRLF chunk-size = 1*HEX last-chunk = 1*("0") [ chunk-extension ] CRLF chunk-extension= *( ";" chunk-ext-name [ "=" chunk-ext-val ] ) chunk-ext-name = token chunk-ext-val = token | quoted-string chunk-data = chunk-size(OCTET) trailer = *(entity-header CRLF) |

其中可以看到,每一个chunk都是可以大小自描述的。

在Nginx的Chunked模块中,header filter函数的流程如下:

1 2 3 4 5 6 7 8 9 10 11 12 | //如果没有content或者是head请求,则直接跳过。 if (r->headers_out.content_length_n == -1) { if (http版本 < http 1.1) { r->keepalive = 0;//关闭keep alive } else { if (开启chunk) { r->chunked = 1; } else { r->keepalive = 0;//也就是,如果关闭了chunk,则也关闭了keep alive。 } } } |

对应的body filter的流程,则更加简单,直接对当前输出的buf chain进行一个chunk封装。

第二、Nginx中Gzip模块和r->headers_out.content_length_n

r->headers_out.content_length_n :这个在Nginx内部用于表述请求返回内容的长度。但注意这不是完全相等的,只有在 r->headers_out.content_length_n >=0的时候,才有意义。比如说,通常后端的upstream(比如说PHP),如果没有在脚本中强制header输出content-length,则默认在nginx中 r->headers_out.content_length_n = -1。

Gzip模块也是一个典型的Filter模块。这里简单介绍下,后续可以详细描述。在header filter中会直接清空 r->headers_out.content_length_n和header中输出的content_length。为什么要清空呢?主要是因为gzip要对内容模块进行压缩处理,而在header filter的时候,gzip模块不可能计算出压缩后的内容长度(原因是在nginx中,header 输出和body的输出是完全两个不同的阶段),所以最好的办法就是在清空header中的content-length。这样结合之前的介绍的chunked模块,可以看出:在nginx中,如果采用gzip,如果是keep alive,则必然是chunked模式。

Upsteam如何和chunked结合

在前面介绍的Nginx Chunked模式实现中提到,Chunked模块的body filter是对当前处理的buf chain进行封装成一个Chunk。那么在Nginx中是如何实现多个Chunk的呢?这里要从 ngx_event_pipe_write_to_downstream这个函数说起,该函数是upstream处理中非常关键的一个函数,用于把upstream返回的数据直接进行输出。

分析该函数的伪代码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 | for() { if (p->downstream_error) { return ngx_event_pipe_drain_chains(p);//出错了 } if (p->upstream_eof || p->upstream_error || p->upstream_done) { //是最后一个节点,或者已经读取upstream数据完毕 //分类比的flush输出,这里面一般都含有bodyfilter比如 rc = p->output_filter(p->output_ctx, p->in); //并且结束循环 p->downstream_done = 1; break; } /*计算当前BUF的size*/ if (bsize >= (size_t) p->busy_size) { /*超过大小则刷数据*/ go flush; } for ( ;; ) { //循环拼装输出buf,如果超过busy_size同样进行flush } flush: //flush输出 rc = p->output_filter(p->output_ctx, out); } |

可以看到,有一个关键点,就是busy_size,它决定了一个chunk的大小。这个对应一个配置,追查后如下:在不同的upstream中有不同的定义,比如说proxy模式下,有proxy_busy_buffers_size,该值默认是proxy buffer size * 2 。(proxy buffer size根据操作系统,可以是4K或者8k)。fastcgi模式下,buffer_size默认是ngx_pagesize。配置项是fastcgi_busy_buffers_size。默认情况下是fastcgi的buffer size的2倍。(buffer size个是可配置的,buffer 个个数也是可以配置的,个数不能小于2)。

Bash下显示历史命令的执行时间

Bash下显示历史命令的执行时间

2012/05/07 19:31 | by ipaddr ]

2012/05/07 19:31 | by ipaddr ]

设置方法:

在/etc/profile 里面加入下面2行就可以了,这样可以记录每个用户执行的命令了。

HISTTIMEFORMAT="%Y-%m-%d %H:%M:%S "

export HISTTIMEFORMAT

注:HISTTIMEFORMAT的格式你可以自己定义,定义成你想要的格式。具体格式可以参照date命令。例如用"%Y-%m-%d %H:%M:%S "格式按照我们中国人的时间格式,"%s " 按照unix时间戳的格式显示。

[转]用Amoeba构架MySQL分布式数据库环境

[转]用Amoeba构架MySQL分布式数据库环境

2012/05/07 19:23 | by ipaddr ]

2012/05/07 19:23 | by ipaddr ]

Amoeba是一个类似MySQL Proxy的分布式数据库中间代理层软件,是由陈思儒开发的一个开源的java项目。其主要功能包括读写分离,垂直分库,水平分库等,经过测试,发现其功能和稳定性都非常的不错,如果需要构架分布式数据库环境,采用Amoeba是一个不错的方案。目前Amoeba一共包括For aladdin,For MySQL和For Oracle三个版本,本文主要关注For MySQL版本的一个读写分离实现。实际上垂直切分和水平切分的架构也相差不大,改动几个配置就可以轻松实现。

下图是一个采用Amoeba的读写分离技术结合MySQL的Master-Slave Replication的一个分布式系统的架构:

Amoeba处于在应用和数据库之间,扮演一个中介的角色,将应用传递过来的SQL语句经过分析后,将写的语句交给Master库执行,将读的语句路由到Slave库执行(当然也可以到Master读,这个完全看配置)。Amoeba实现了简单的负载均衡(采用轮询算法)和Failover。如果配置了多个读的库,则任何一个读的库出现宕机,不会导致整个系统故障,Amoeba能自动将读请求路由到其他可用的库上,当然,写还是单点的依赖于Master数据库的,这个需要通过数据库的切换,或者水平分割等技术来提升Master库的可用性。

Amoeba可以在不同机器上启动多个,并且做同样的配置来进行水平扩展,以分担压力和提升可用性,可以将Amoeba和MySQL装在同一台机器,也可以装在不同的机器上,Amoeba本身不做数据缓存,所以对于内存消耗很少,主要是CPU占用。对于应用来说,图中的三个Amoeba就是三台一模一样的MySQL数据库,连接其中任何一台都是可以的,所以需要在应用端有一个Load balance和Failover的机制,需要连接数据库时从三台中随机挑选一台即可,如果其他任何一台出现故障,则可以自动Failover到剩余的可用机器上。MySQL的JDBC驱动从connector-j 3.17版本起已经提供了这样的负载均衡和故障切换的功能,那么剩下的事情对于应用来说就很简单了,不需要做太多的改动就能搭建一套高可用的MySQL分布式数据库环境,何乐而不为?

[转]双向同步软件Unison的安装与配置

[转]双向同步软件Unison的安装与配置

2012/05/07 18:55 | by ipaddr ]

2012/05/07 18:55 | by ipaddr ]

一、Unison简介

Unison是Windows、Linux以及其他Unix平台下都可以使用的文件同步工具,它能使两个文件夹(本地或网络上的)保持内容的一致。Unison拥有与其它一些同步工具或文件系统的相同的特性,但也有自身的特点:

1.跨平台使用;

2.对内核和用户权限没有特别要求;

3.Unison是双向的,它能自动处理两分拷贝中更新没有冲突的部分,有冲突的部分将会显示出来让用户选择更新策略;

4.只要是能连通的两台主机,就可以运行unison,可以直接使用socket连接或安全的ssh连接方式,对带宽的要求不高,使用类似rsync的压缩传输协议。

二、编译安装Unison

Linux下通过源码包编译安装Unison时,需要用到Objective Caml compiler。

通过以下方式安装

[root@server1 ~]# wget http://caml.inria.fr/pub/distrib/ocaml-3.12/ocaml-3.12.0.tar.gz

[root@server1 ~]# tar -xzvf ocaml-3.12.0.tar.gz

[root@server1 ~]# cd ocaml-3.12.0

[root@server1 ocaml-3.12.0]# ./configure

[root@server1 ocaml-3.12.0]# make world opt

[root@server1 ocaml-3.12.0]# make install

编译安装Unison

[root@server1 ~]# wget http://www.seas.upenn.edu/~bcpierce/unison//download/releases/stable/unison-2.40.63.tar.gz

[root@server1 ~]# tar -xzvf unison-2.40.63.tar.gz

[root@server1 ~]# cd unison-2.40.63

[root@server1 unison-2.40.63]# make UISTYLE=text

[root@server1 unison-2.40.63]# make install

在执行make install的过程中,可能会出现以下错误提示:

mv: cannot stat '/root/bin//unison': No such file or directory

make: [doinstall] Error 1 (ignored)

cp unison /root/bin/

cp: cannot create regular file '/root/bin/': Is a directory

make: *** [doinstall] Error 1

出现错误的原因在与Unison默认是将文件Copy到/root/bin目录,但Linux默认是没有该目录的,因此我们需要将生成的可执行文件unison复制到系统的PATH目录。

[root@server1 unison-2.40.63]# cp unison /usr/local/bin

将可执行文件unison上传到远程主机(假设远程主机IP为192.168.10.4)

[root@server1 unison-2.40.63]# scp unison root@92.168.10.4:/root/

通过SSH登陆到远程主机,再将unison复制到server2的PATH目录

[root@server2 ~]#cp unison /usr/local/bin

三、配置ssh key信任

建议通过普通用户进行操作,理由是通过root操作本身就危险,免密码登陆的root就更危险了。

在两台服务器上创建unison用户

[root@server1 ~]# useradd -m unison

[root@server1 ~]# passwd unison

[root@server2 ~]# useradd -m unison

[root@server2 ~]# passwd unison

在server1上创建key并配置server2的信任

[root@server1 ~]# su – unison

[unison@server1 ~]$ ssh-keygen -t rsa

在提示保存私钥(key)和公钥(public key)的位置时,使用默认值;

在提示是否需要私钥密码(passphrase)时,直接敲回车,即不使用私钥密码。

之后,将生成一对密钥,id_rsa(私钥文件)和id_rsa.pub(公钥文件),保存在/home/unison/.ssh/目录下。

将公钥添加到server2的 authorized_keys 文件中

将文件上传到server2(假设server2主机IP为192.168.10.4)

[unison@server1 ~]$ scp ~/.ssh/id_rsa.pub unison@192.168.10.4:/home/unison/

使用rsync用户SSH到登陆到远程主机,并将公钥添加到 authorized_keys 文件中

[unison@server2 ~]$ mkdir .ssh

[unison@server2 ~]$ chmod 700 .ssh

[unison@server2 ~]$ mv ~/id_rsa.pub ~/.ssh/authorized_keys

同理,执行以下步骤在server2上创建key并配置server1的信任

[root@server2 ~]# su – unison

[unison@server2 ~]$ ssh-keygen -t rsa

将文件上传到server1(假设server1主机IP为192.168.10.3)

[unison@server2 ~]$ scp ~/.ssh/id_rsa.pub unison@192.168.10.3:/home/unison/

使用rsync用户SSH到登陆到server1,并将公钥添加到 authorized_keys 文件中

[unison@server1 ~]$ mv ~/id_rsa.pub ~/.ssh/authorized_keys

重启SSH服务

[root@server1 ~]# /etc/init.d/sshd restart

[root@server2 ~]# /etc/init.d/sshd restart

四、Unison的配置与使用

在两台服务器上创建test目录,用于测试

[root@server1 ~]# su - unison

[unison@server1 ~]$ mkdir test

[root@server2 ~]# su - unison

[unison@server2 ~]$ mkdir test

在两台服务器上分别执行一次unison,如果出现提示确认,则直接敲回车选择默认值

[unison@server1 ~]$ unison /home/unison/test/ ssh://unison@192.168.10.4//home/unison/test/

[unison@server2 ~]$ unison /home/unison/test/ ssh://unison@192.168.10.3//home/unison/test/

修改两台服务器的unison配置文件,输入以下内容

[unison@server1 ~]$ vim /home/unison/.unison/default.prf

#Unison preferences file

root = /home/unison/test

root = ssh://unison@192.168.10.4//home/unison/test/

#force =

#ignore =

batch = true

#repeat = 1

#retry = 3

owner = true

group = true

perms = -1

fastcheck = false

rsync = false

sshargs = -C

xferbycopying = true

log = true

logfile = /home/unison/.unison/unison.log

[unison@server2 ~]$ vim /home/unison/.unison/default.prf

#Unison preferences file

root = /home/unison/test

root = ssh://unison@192.168.10.3//home/unison/test/

#force =

#ignore =

batch = true

#repeat = 1

#retry = 3

owner = true

group = true

perms = -1

fastcheck = false

rsync = false

sshargs = -C

xferbycopying = true

log = true

logfile = /home/unison/.unison/unison.log

相关注解如下:

force表示会以本地所指定文件夹为标准,将该目录同步到远端。这里需要注意,如果指定了force参数,那么Unison就变成了单项同步了,也就是说会以force指定的文件夹为准进行同步,类似与rsync。

Unison双向同步基本原理是:假如有A B两个文件夹,A文件夹把自己的改动同步到B,B文件夹也把自己的改动同步到A,最后A B两文件夹的内容相同,是AB文件夹的合集。

Unison双向同步的一个缺点是,对于一个文件在两个同步文件夹中都被修改时,unison是不会去同步的,因为unison无法判断以那个为准。

ignore = Path表示忽略指定目录,即同步时不同步它。

batch = true,表示全自动模式,接受缺省动作,并执行。

-fastcheck true 表示同步时仅通过文件的创建时间来比较,如果选项为false,Unison则将比较两地文件的内容。

log = true 表示在终端输出运行信息。

logfile 指定输出的log文件。

另外,Unison有很多参数,这里仅介绍常用的几个,详细的请参看Unison手册。

-auto //接受缺省的动作,然后等待用户确认是否执行。

-batch //batch mode, 全自动模式,接受缺省动作,并执行。

-ignore xxx //增加 xxx 到忽略列表中

-ignorecase [true|false|default] //是否忽略文件名大小写

-follow xxx //是否支持对符号连接指向内容的同步

owner = true //保持同步过来的文件属主

group = true //保持同步过来的文件组信息

perms = -1 //保持同步过来的文件读写权限

repeat = 1 //间隔1秒后,开始新的一次同步检查

retry = 3 //失败重试

sshargs = -C //使用ssh的压缩传输方式

xferbycopying = true"

-immutable xxx //不变目录,扫描时可以忽略

-silent //安静模式

-times //同步修改时间

-path xxx 参数 //只同步 -path 参数指定的子目录以及文件,而非整个目录,-path 可以多次出现。

PS:Windows下的unison配置文件默认位于C:\Documents and Settings\currentuser\.unison目录,默认的配置文件名是default.prf。

五、测试

首先分别在server1与server2的/home/unison/test目录下创建文件或目录,然后在server1上执行unison,接着如果在server1与server2上都能看到各自创建的文件,就说明同步成功。

分别在server1与server2上创建文件

[unison@server1 ~]$ cd test

[unison@server1 test]$ touch 1.txt touch 3.txt

[unison@server2 ~]$ cd test

[unison@server2 test]$ touch 2.txt touch 4.txt

在server1上执行unison

[unison@server1 ~]$ unison

在server1与server2上查看文件是否同步

[unison@server1 ~]$ cd test

[unison@server1 test]$ ls

1.txt 2.txt 3.txt 4.txt

[unison@server2 ~]$ cd test

[unison@server2 test]$ ls

1.txt 2.txt 3.txt 4.txt

均看到了“1.txt 2.txt 3.txt 4.txt”所有文件,说明文件同步已经成功!

注意:第一次SSH连接的时候可能需要输入一次密码,之后就不需要输入了。

六、定期或实时执行同步

如果想要定期执行,则通过crontab计划任务来实现,例如通过以下方式设置每5分钟执行一次

[root@server1 ~]# su - unison

[unison@server1 ~]$ crontab -e

*/5 * * * * /usr/local/bin/unison

[转]通过rsync+inotify-tools+ssh实现触发式远程实时同步

[转]通过rsync+inotify-tools+ssh实现触发式远程实时同步

2012/05/07 18:44 | by ipaddr ]

2012/05/07 18:44 | by ipaddr ]

文件的同步镜像在很多地方都需要用到,因此rsync这款免费软件得到了广泛的应用,包括在Windows平台上,都已经有了支持rsync的“cwRsyncServer”。

但是,我们一般都是通过结合crontab计划任务来实现文件同步的,这样做的缺点是效率低,不能做到实时同步。

现在,在Linux平台下我们可以利用2.6内核的inotify监控文件系统机制,通过inotify-tools来实现实时同步了。

具体操作如下:

1.安装所需软件

目前各大Linux发行版本都已经具有了rsync与inotify-tools的软件包,推荐通过RPM,yum,apt-get等方式进行安装。

RHEL:

[root@server1 ~]# rpm -ivh rsync-*

[root@server1 ~]# rpm -ivh inotify-tools-*

CentOS:

[root@server1 ~]# yum install rsync inotify-tools

Ubuntu:

[root@server1 ~]# apt-get install rsync inotify-tools

采用源码方式安装的步骤如下:

[root@server1 ~]# wget ftp://ftp.samba.org/pub/rsync/rsync-3.0.8.tar.gz

[root@server1 ~]# tar xzvf rsync-3.0.8.tar.gz

[root@server1 ~]# cd rsync-3.0.8

[root@server1 ~]# ./configure

[root@server1 ~]# make

[root@server1 ~]# make install

[root@server1 ~]# wget http://github.com/downloads/rvoicilas/inotify-tools/inotify-tools-3.14.tar.gz

[root@server1 ~]# tar xzvf inotify-tools-3.14.tar.gz

[root@server1 ~]# cd inotify-tools-3.14

[root@server1 ~]# ./configure

[root@server1 ~]# make

[root@server1 ~]# make install

2.配置ssh key信任

建议通过普通用户进行操作,理由是通过root操作本身就危险,免密码登陆的root就更危险了。

在两台服务器上创建rsync用户

[root@server1 ~]# useradd -m rsync

[root@server1 ~]# passwd rsync

[root@server2 ~]# useradd -m rsync

[root@server2 ~]# passwd rsync

[root@server1 ~]# su - rsync

[rsync@server1 ~]$ ssh-keygen -t rsa

在提示保存私钥(key)和公钥(public key)的位置时,使用默认值;

在提示是否需要私钥密码(passphrase)时,直接敲回车,即不使用私钥密码。

之后,将生成一对密钥,id_rsa(私钥文件)和id_rsa.pub(公钥文件),保存在/home/rsync/.ssh/目录下。

将公钥添加到远程主机的 authorized_keys 文件中

将文件上传到远程主机(假设远程主机IP为192.168.10.4)

[rsync@server1 ~]$ scp ~/.ssh/id_rsa.pub rsync@192.168.10.4:/home/rsync/

使用rsync用户SSH到登陆到远程主机,并将公钥添加到 authorized_keys 文件中

[rsync@server2 ~]$ mkdir .ssh

[rsync@server2 ~]$ chmod 700 .ssh

[rsync@server2 ~]$ mv ~/id_rsa.pub ~/.ssh/authorized_keys

重启SSH服务

[root@server1 ~]# /etc/init.d/sshd restart

[root@server2 ~]# /etc/init.d/sshd restart

3.创建inotify_rsync.sh脚本

[root@server1 ~]# vim inotify_rsync.sh

#!/bin/sh

SRC=/home/rsync/test

DST=rsync@192.168.10.4:/home/rsync/test

/bin/su - rsync

/usr/local/bin/inotifywait -mrq -e modify,delete,create,attrib ${src} | while D E F

do

/usr/bin/rsync -ahqzt --delete $SRC $DST

done

相关注解如下:

/usr/local/bin/inotifywait -mrq -e modify,delete,create,attrib ${src}

-m 是保持一直监听

-r 是递归查看目录

-q 是打印出事件

-e create,move,delete,modify,attrib 是指 “监听 创建 移动 删除 写入 权限” 事件

/usr/bin/rsync -ahqzt --delete $SRC $DST

-a 存档模式

-h 保存硬连接

-q 制止非错误信息

-z 压缩文件数据在传输

-t 维护修改时间

-delete 删除于多余文件

要排除同步某个目录时,为rsync添加--exculde=PATTERN参数,注意,路径是相对路径,具体查看man rsync。

要排除某个目录的事件监听的处理时,为inotifywait添加--exclude或--excludei参数,具体查看man inotifywait。

inotifywait 命令产生三个返回值,分别是“日期,时间,文件” 这3个返回值会做为参数传给read,因此脚本中的“while read D E F” 写法细化了返回值。

赋予脚本可执行权限

[root@server1 ~]# chmod +x inotify_rsync.sh

执行脚本

[root@server1 ~]# /root/inotify_rsync.sh &

设置脚本开机自启动

[root@server1 ~]# cat "/root/inotify_rsync.sh &" >> /etc/rc.local

4.测试

首先在server1服务器的/home/rsync/test目录下创建文件或目录,然后再到server2的/home/rsync/test目录下查看,如果看到就说明成功了。

[rsync@server1 ~]$ cd test

[rsync@server1 test]$ touch a.txt

注意:第一次SSH连接的时候可能需要输入一次密码,之后就不需要输入了。

[rsync@server2 ~]$ cd test

[rsync@server2 test]$ ls

a.txt

看到了a.txt文件,说明文件同步已经成功!